扣丁学堂大数据在线学习 浅谈Hadoop在互联网数据服务中的生命周期

随着互联网技术的飞速发展,大数据已成为企业和组织决策的重要支撑。Hadoop作为大数据处理的核心框架之一,自诞生以来在数据存储、计算和分析领域发挥了关键作用。本文将从Hadoop的技术演进、当前应用现状以及未来前景,探讨其在互联网数据服务中的生命周期。

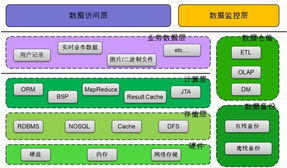

Hadoop的生命周期可以追溯到2006年,由Apache软件基金会推出,它基于Google的MapReduce和GFS论文设计,旨在解决海量数据的分布式处理问题。在早期阶段,Hadoop凭借其高容错性和可扩展性,迅速成为企业大数据平台的首选,广泛应用于日志分析、用户行为追踪等互联网数据服务场景。这一时期,Hadoop的生命周期处于快速增长期,许多公司如Yahoo、Facebook等大规模部署Hadoop集群,推动了其生态系统的完善,包括HDFS、MapReduce、Hive和HBase等组件。

随着技术环境的变迁,Hadoop的生命周期也面临挑战。云计算、容器化和实时处理技术的兴起,使得一些新兴框架如Spark、Flink等在特定场景下表现更优,导致Hadoop在某些互联网数据服务中的使用率有所下降。例如,Spark的内存计算能力在处理迭代算法和流数据时效率更高,而云服务商提供的托管解决方案减少了对自建Hadoop集群的依赖。这表明Hadoop的生命周期可能已进入成熟期或调整期,但其核心组件如HDFS仍然在许多混合云和多云环境中作为数据湖的基础存储层。

从长远来看,Hadoop的生命周期并未终结。在互联网数据服务中,Hadoop依然在批处理、历史数据分析和成本敏感型应用中占据重要地位。许多企业通过集成Hadoop与新兴技术,实现混合架构,以平衡性能与成本。Hadoop生态系统不断进化,例如通过YARN资源管理支持多种计算框架,延长了其生命周期。预计在未来5-10年内,Hadoop仍将作为大数据基础设施的一部分,服务于互联网数据存储、ETL流程和机器学习管道。

Hadoop的生命周期在互联网数据服务中经历了从兴起、成熟到转型的过程。尽管面临竞争,但其可靠性、社区支持和成本效益确保了其在特定应用中的持久性。对于学习者而言,通过扣丁学堂等在线平台掌握Hadoop技术,不仅能理解大数据基础,还能为应对未来技术演变做好准备。Hadoop的生命周期长短取决于企业如何将其与创新技术结合,以适应快速变化的互联网数据需求。

如若转载,请注明出处:http://www.rodmfi.com/product/25.html

更新时间:2026-03-01 11:54:25